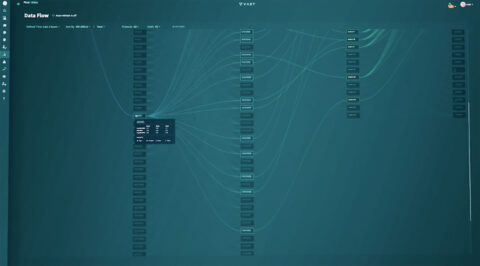

La société d’animation recourt depuis plusieurs années à la technologie développée par VAST pour répondre aux exigences techniques de l’équipe créative de Pixar afin d’alimenter le pipeline de rendu exigeant pour Elemental, l’une des dernières productions. En déplaçant 7,3 pétaoctets de données vers un seul cluster de stockage de données géré à travers un espace de haute performance organisé à partir de flash à faible coût, VAST fournit un accès en temps réel. Le but est de mieux gérer les datas, une collaboration et un développement simplifiés entre plusieurs productions exécutées en même temps, et en posant les bases pour exploiter l’IA pour les futurs films.

Pouvez-vous nous dire comment VAST soutient l’infrastructure de Pixar et répond à ses besoins en matière de workflows de données ?

Éric Bermender : Quand nous travaillions sur Soul, nous avons lancé un nouveau process permettant de réaliser des personnages volumétriques : au lieu de formes géométriques animées et de textures – comme c’était le cas, disons, dans Toy Story –, les personnages étaient représentés par des simulations. Or, avec les méthodes que nous utilisions jusqu’alors pour l’animation, cette nouvelle approche posait des problèmes de stockage. Prenez Buzz l’Éclair, par exemple : il est simplement composé d’un squelette recouvert d’une texture, et il suffit de placer ces éléments-là dans une mémoire cache afin de créer rapidement les déplacements de Buzz.

Mais les personnages volumétriques, en revanche, ne sont pas définis par une simple forme géométrique et n’ont pas de textures. Pour eux, chaque image est le résultat d’une simulation, ce qui signifie qu’il est impossible de placer leurs données en mémoire cache. Qui plus est, n’importe quel autre changement dans la scène influe sur le résultat de la simulation, et le personnage doit donc être recréé à chaque fois. En pratique, cela s’est traduit par une explosion de nos besoins en matière de transmission de données et d’accès au stockage.

Lorsque nous avons commencé Soul nous venions de rencontrer VAST, qui était encore un acteur très discret sur le marché, et leur technologie semblait répondre parfaitement à nos besoins précis : un serveur de fichiers à la fois très rapide et très flexible. Si nous étions restés sur notre approche précédente, il nous aurait fallu remplir de nombreux racks de serveurs pour atteindre la capacité souhaitée !

Ces personnages volumétriques sont-ils maintenant utilisés dans tous les films de Pixar ?

E.B. : L’approche a beaucoup réussi à Soul, et nous nous sommes donc naturellement demandé si elle pouvait être appliquée aux personnages de nos autres projets : mais pour certains d’entre eux, le recours au process volumétrique aurait demandé jusqu’à six fois plus de capacité de calcul que Soul ! Pour l’instant, nous utilisons donc les personnages volumétriques de manière ponctuelle, lorsque la situation le justifie, et nous continuerons de le faire. Ce process a notamment beaucoup servi dans Élémentaire, et il permet à nos artistes d’enrichir leur boîte à outils même s’ils ne l’utilisent pas de manière systématique.

Avez-vous également utilisé la plate-forme de VAST pour d’autres projets ?

E.B. : Notre pipeline de création est divisé en différents workflows et, en fonction de nos besoins en matière de transmission et de conservation de données pour chacun de ces workflows, nous avons recours à différents serveurs de fichiers. Au début, le système VAST ne servait que pour le workflow des personnages volumétriques, mais il s’est depuis élargi : chacune des productions de Pixar depuis Soul utilise la technologie de VAST, mais pas pour tous ses différents workflows. Qui plus est, nous avons transféré sur VAST toute notre archive de films depuis même avant Toy Story, c’est-à-dire les différentes « prises » et les scènes finales de toutes nos productions. Tous les artistes peuvent donc y accéder à des fins de référence.

Combien de films sont en cours de production en parallèle ?

E.B. : Généralement, nous avons entre deux et quatre projets « actifs », c’est-à-dire pour lesquels nos serveurs informatiques sont sollicités. Un projet Pixar demande en moyenne quatre ou cinq ans, mais les trois premières années sont principalement consacrées au storyboarding et à la préparation des scènes : autrement dit, le travail sur les images de synthèse proprement dites n’intervient que vers la fin. Donc si je devais parler du nombre de projets « actifs » en parallèle, il faudrait inclure ceux-là… mais si l’on parle uniquement de ceux qui en sont au stade de la création des images finales par les graphistes, il y en a bien entre deux et quatre qui sont à différentes étapes du processus. Par exemple, il faut d’abord faire le placement des « caméras » et les poses des personnages, ensuite l’animation, et enfin l’éclairage, très gourmand en puissance de calcul puisque c’est à cette étape-là qu’est fait le rendu.

Avez-vous des chiffres sur l’augmentation des volumes de données traitées sur les cinq dernières années ?

E.B. : Oui, et nos responsables financiers me demandent sans cesse des comptes à ce sujet ! Globalement, nous observons un doublement de nos besoins en matière de données tous les trois à cinq ans. J’ai fait une analyse en remontant jusqu’en 1995, et cette tendance se vérifie sur la durée même si Élémentaire représente une exception notable puisqu’il a nécessité trois ou quatre fois notre capacité habituelle. Cela étant dit, nos besoins concrets peuvent également enregistrer des variations importantes d’une année sur l’autre en fonction du nombre de projets sur lesquels nous travaillons en simultané.

Pour Élémentaire, cette multiplication de vos besoins est-elle due à l’utilisation de personnages volumétriques, ou bien à d’autres facteurs comme la résolution, la complexité de l’éclairage, etc. ?

E.B. : D’autres composants du pipeline ont demandé une capacité accrue, notamment en raison du nombre de canaux que nous prenons en charge, mais si Élémentaire a fait figure d’exception parmi nos projets c’est principalement, en effet, en raison des personnages volumétriques.

On parle beaucoup de l’IA en ce moment et je crois comprendre que la technologie de VAST y a recours elle aussi ? De quelle manière ?

E.B. : En ce moment, nous posons les bases d’une potentielle utilisation de l’IA à plus grande envergure dans l’avenir. Nous n’utilisons pour l’instant que très peu d’IA : c’est un outil qui nous sert uniquement pour une fonction précise, à savoir l’élimination du bruit dans RenderMan. À partir de projets précédents que nous lui fournissons – il s’agirait donc d’apprentissage machine plutôt que d’IA –, cette fonction apprend à flouter certaines parties d’une scène afin de réduire le bruit à l’écran. Nous l’utilisons en fait depuis Toy Story 4, donc avant l’engouement actuel pour l’IA.

Le nerf de la guerre dans ce domaine, ce sont souvent les données d’apprentissage ; or, je pense que nous possédons l’une des plus importantes collections de données d’apprentissage au monde pour le cinéma d’animation… d’où l’importance d’avoir transféré sur une plate-forme VAST l’intégralité de notre archive, dont je parlais tout à l’heure. Grâce à VAST, nous pouvons facilement augmenter à la fois notre capacité de stockage et notre capacité de calcul, de manière séparée, ce qui est important. En effet, nous utilisons énormément le protocole NFS et avons donc besoin d’une latence très faible, mais également d’une importante puissance de calcul, ce que les concurrents de VAST ne nous offrent pas forcément.

Le plus souvent, un fournisseur de solutions de stockage vend une boîte qui inclut une certaine quantité de stockage et une certaine capacité de calcul ; or, si je souhaite augmenter uniquement ma capacité de calcul, je n’ai pas d’autre choix que d’acheter des boîtes supplémentaires, et donc du stockage dont je n’ai pas besoin. Mais comme VAST permet d’acquérir soit des boîtes « calcul », soit des boîtes « stockage », je peux augmenter l’un ou l’autre selon mes besoins précis.

La plate-forme de VAST est ainsi particulièrement prometteuse pour explorer l’utilisation de l’IA à l’avenir, puisqu’elle permet de mettre en place des nœuds de calcul destinés spécifiquement à l’apprentissage machine en utilisant par exemple GPUDirect RDMA pour analyser des données déjà présentes sur le système VAST. Il ne nous restera alors plus qu’à choisir un pipeline d’IA pour nos contenus.

Toutes ces données sont-elles accessibles à distance ?

E.B. : Non, nous gardons tout en interne et stockons nos données sur un seul site, notamment en raison de l’importance que nous accordons à la latence. À l’heure actuelle, le protocole le plus rapide pour nous est NFSv3, avec lequel les données sont transmises au format POSIX. Nous avons fait des expériences avec le cloud, mais c’était toujours la latence qui posait problème… et j’ai souvent dû rappeler à nos dirigeants les bases de la transmission de données : impossible d’aller plus vite que la lumière !

Maintenant une question pour Andy [Pernsteiner, CTO de VAST] : quel est votre modèle économique ?

Andy Pernsteiner : Les clients qui souhaitent déployer VAST doivent faire l’acquisition du matériel séparément, auprès d’un fabricant. Nos systèmes sont ensuite basés sur des licences qui dépendent de deux facteurs : la capacité et la durée d’engagement. Nous offrons une certaine flexibilité, par exemple le client peut acheter du matériel permettant une certaine capacité maximale tout en ne prenant une licence que pour une partie de cette capacité, selon ses besoins.

Comme l’a expliqué Éric, il est possible d’augmenter seulement la puissance de calcul indépendamment de la capacité de stockage ; dans ce cas, puisque seule la capacité entre en compte dans le prix, le client ne verse rien de plus à VAST et il lui suffit d’acheter le matériel. De plus, étant donné que le matériel de calcul est moins coûteux que le matériel de stockage, cette augmentation de la puissance de calcul peut se faire sans engager de dépenses importantes.

VAST vise-t-il une clientèle de très grands acteurs ou sa technologie est-elle accessible aux structures de plus petite envergure ?

A.P. : C’est avant tout une question de capacité. À l’heure actuelle, pour que VAST en vaille la peine, un client doit avoir au moins 500 To de données environ : en deçà, nous n’apportons pas vraiment de valeur ajoutée. Dans le modèle traditionnel, le client stocke ses données les plus importantes sur un système très rapide – et donc coûteux –, tandis que le reste des données est sur une autre plate-forme moins performante. Avec VAST, cela devient intéressant de stocker l’intégralité des données sur une seule plate-forme très rapide, alors qu’il serait prohibitif de faire l’équivalent sur une plate-forme concurrente.

Le marché des médias et du divertissement est-il stratégique pour vous ?

E.B. : C’est un marché stratégique, mais je ne dirais pas que c’est notre marché le plus important. Le profil « traditionnel » du client de VAST est un client qui possède énormément de données qu’il doit traiter avec un niveau élevé de performance, avec beaucoup d’accès simultanés. C’est clairement le cas de Pixar, et il est vrai que la technologie de VAST se prête particulièrement bien aux workflows de rendu, par opposition à d’autres workflows comme la postproduction, les effets visuels ou encore les couleurs : ces derniers demandent eux aussi une importante puissance de calcul, mais pas à très grande échelle, ce qui est la spécialité de VAST.

Article paru pour la première fois dans Mediakwest #53, p. 92-94