Comme dans tous les domaines de l’audiovisuel, le monde du broadcast a entrepris sa mutation vers les réseaux IP. © DR

Comme dans tous les domaines de l’audiovisuel, le monde du broadcast a entrepris sa mutation vers les réseaux IP. © DR

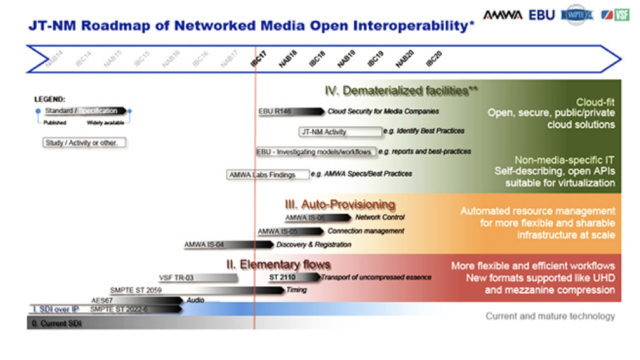

Pour la production live, la SMPTE a démarré il y a plusieurs années un important travail de normalisation, concrétisé par la publication des standards SMPTE ST 2110. Autour du même sujet, est apparu le sigle NMOS avec ses spécifications IS. Ce travail normatif de tous les éléments de la vidéo IP dans un environnement broadcast est encore loin d’être achevé.

Le transport d’un signal vidéo de qualité broadcast sur un réseau IP dans un environnement de production live combine un nombre élevé de paramètres, des mécanismes complexes et des configurations largement plus nombreuses que pour une simple architecture SDI.

La production des …

Abonnez-vous dès maintenant

Accédez en illimité à tous les articles aux dossiers, aux magazines, aux newsletters exclusives…

Je m'abonne Déja un compte? Je me connecte