En France, si le savoir-faire est réel, le nombre de prestataires s’est raréfié. L’éditeur parisien de jeux vidéo Quantic Dream, équipé en interne de 64 caméras Vicon à 16 millions de pixels, répond ponctuellement à des demandes de prestation. Les deux principaux prestataires en MoCap optique sont Mocaplab et SolidAnim. Fondé par Rémi Brun, Mocaplab s’est installé dans ses nouveaux locaux à Aubervilliers il y a un an. Cette année, l’équipement de son plateau de MoCap passe à 40 caméras Vicon T160 à 16 millions de pixels. SolidAnim a préféré installer ses caméras à Angoulême et à Bordeaux. Leur dernière production marquante est Croc-Blanc, un long-métrage en images de synthèse produit par Superprod, réalisé par Alexandre Espigares et sorti sur les écrans le 28 mars 2018. Les mouvements des humains, mais aussi du chien, ont été saisis en MoCap suivant un pipeline comprenant SolidTrack, un outil développé par SolidAnim pour le suivi temps réel des positions de la caméra sur le tournage. Toujours en quête d’innovations, le prestataire a en développement « Gleam Session », un logiciel qui permet d’enregistrer simultanément voix et animations faciales.

Le cinéma pour l’image de marque

Les prestations sur les longs-métrages représentent la partie émergée et médiatisée de l’iceberg. En France, les besoins en VFX sont réduits, et encore plus en MoCap ; aussi SolidAnim va chercher ses projets à l’international. Concernant Mocaplab, leur prestation récente sur Valérian et la cité des mille planètes en 2017, de Luc Besson, représente une exception. La MoCap du projet a été confiée aux poids lourds du secteur que sont Weta Digital, ILM et Rodeo FX. Mocaplab est intervenu comme sous-traitant de Weta Digital pour le tournage qui s’est tenu à la Cité du Cinéma. « Weta fait de la performance capture avec des moyens importants, une très grosse équipe mobilisant une vingtaine de personnes et un scan 3D complet du plateau toutes les demi-heures », confie Rémi Brun. « À l’opposé du spectre, nous avons travaillé sur la mini-série vidéo-ludique Life is Strange en 2015, produite par Dontnod Entertainment et Square Enix, qui comprend cinq épisodes de 30 minutes. » Ce jeu narratif a connu un succès mondial avec plus de trois millions de joueurs payants. Chaque épisode a demandé environ 90 minutes d’histoire temps réel à réaliser, soit environ quatre heures de captation de mouvements mono-personnage. Mocaplab a mis en place un pipe spécifique efficace pour arriver à produire un épisode par semaine, avec un soin apporté au facial. « Au final, nos projets sont disparates avec toujours un peu de R&D par exemple afin d’aider à la reconstruction maxillo-faciale. Nous nous sommes forgés une méthodologie pour la capture des doigts, et le langage des signes est un sujet récurrent pour nous, avec une série TV en préparation et une application qui va sortir sur smartphone », poursuit Rémi Brun. En attendant de travailler sur une série TV qui pourrait assurer une activité régulière, chaque projet demande une configuration spéciale et le prestataire n’hésite pas à déplacer son studio de MoCap pour faire des tournages dans d’autres lieux, par exemple pour capter les mouvements d’un cheval, d’un tournoi de tennis ou des acrobaties faites au trampoline…

L’enjeu du facial

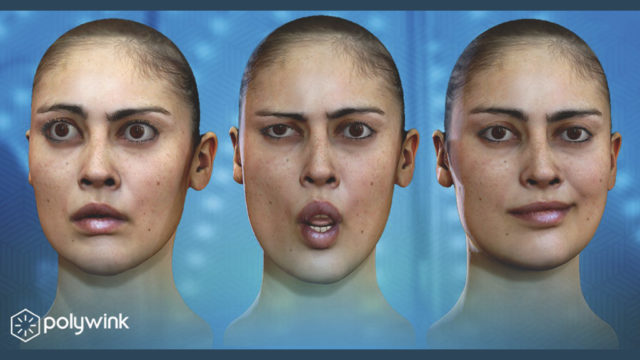

« Si la captation des mouvements du corps est rodée, la frontière de l’innovation est davantage en facial où il existe plusieurs approches techniques, avec ou sans marqueurs pour plus de légèreté. Une bonne capture est le préliminaire, mais il est aussi indispensable d’avoir un rig facial de qualité. L’animation faciale est très difficile, le savoir-faire est technico-artistique et il faut soigner les micro-détails », souligne Stéphane Dalbera. La difficulté en motion capture est de capter simultanément les expressions du visage et les mouvements du corps, pour lesquels la précision demandée n’est pas la même. Deux passes séparées peuvent être tournées puis assemblées. Une autre option est de munir la tête des acteurs de casques avec une caméra frontale qui va capturer les mouvements de marqueurs placés sur le visage pendant que les caméras périphériques viennent saisir les mouvements de leurs corps. Par exemple le système Facets, développé par Weta Digital, ou le casque Cara de Vicon, à quatre caméras, fonctionnent sur ce principe. La précision des caméras Vicon à 16 millions de pixels permet d’envisager des prises corps et facial simultanément, pour des actions quasi statiques comme un chanteur ou un musicien. « Nous avons équipé en Vicon à 16 millions de pixels, la plate-forme de recherche “Technologie Sport Santé” du Centre d’innovation de l’UTC », confie ainsi El Mostafa Laassel, président de Biometrics France. « Pour capturer les mimiques du visage d’un musicien, des marqueurs très fins de diamètre 1,5 mm sont posés sur le visage avec de petites pinces et fixés au blanc d’oeuf. La précision de saisie obtenue est inférieure au 1/10 de mm ». La France compte deux sociétés innovantes sur le sujet du facial, Dynamixyz qui a développé Performer, une solution logicielle de captation des expressions faciales sans capteurs par une seule caméra, complétée depuis par une réponse avec capteurs et Eisko, anciennement ADN (Agence de la Doublure Numérique). Ce spécialiste de la création de clones numériques a élargi son scope ces dernières années.

Du cinéma au téléphone mobile

Eisko a développé son propre système de capture, qui a évolué avec un système tête et corps et l’usage de 4 000 Led au lieu de 1 600. Une cellule de scan photogrammétrique vient enregistrer les différentes expressions d’un visage avec les textures et les matériaux. Le modèle neutre 3D du visage est reconstruit avec une géométrie détaillée et les textures. Un moteur de simulation physique permet d’animer chaque expression en utilisant des rigs de contrôle spécialement adaptés à la complexité du visage. « Notre offre couvre les secteurs de l’animation précalculée, de l’interactif et du jeu vidéo, la RV et la RA, mais aussi les nouvelles applications pour le web et le mobile », présente Cédric Guiard, président d’Eisko. La prestation faciale fournie par Eisko est généralement associée à une MoCap plus traditionnelle du corps. En VFX, pour le long-métrage Moi, Tonya (2017), le prestataire a été sollicité pour une séquence de patinage où le visage d’une patineuse professionnelle devait être remplacé par celui de l’actrice Margot Robbie. Le système de capture d’expressions faciales a été transporté à Atlanta sur le lieu du tournage. Les effets visuels, remplacement de visages, multiplication de foule, etc., ont été confiés au studio Eight VFX. « En événementiel, nous avons travaillé pour faire, lors de nouveaux spectacles, une projection holographique d’un clone virtuel du chanteur hollandais André Hazes décédé en 2004. Sur ce projet, le modèle a été reconstruit à partir d’images d’archives. La MoCap de l’imitateur avec ses marqueurs faciaux a été confiée à Mocaplab et réalisée en même temps que la prise de vue réelle », continue Cédric Guiard. À partir du tracking tête et caméra, le visage de l’imitateur a pu être remplacé en postproduction par celui du chanteur décédé. Eisko développe aussi des services web comme polywink.com. Suivant le segment de marché visé et le niveau de délité demandé, Eisko va faire appel au choix à de la MoCap optique chez Mocaplab ou SolidAnim ou à du vidéo-tracking comme chez Dynamixyz par exemple pour des personnages secondaires. Eisko est aussi sollicité pour la réalisation de doubles numériques d’athlètes comme par exemple en tennis pour le jeu vidéo Tennis World Tour produit par Breakpoint et Bigben Interactive, qui va sortir en mai 2018. Le temps réel, que ce soit pour des applications VR ou le jeu vidéo, est un domaine en demande d’animations à base de MoCap. « Nous faisons beaucoup de prestations pour Ubisoft, comme pour le trailer Wildland du jeu Ghost Recon créé par le studio Mathematic, pour lequel nous avons fait de la très belle MoCap corps et doigts », confirme Rémi Brun.

Une qualité plus abordable

Globalement la MoCap de qualité est toujours coûteuse, bien qu’un peu moins chère, et a un peu évolué, offrant davantage de précision, une vitesse plus grande, de l’auto-calibrage… Par ailleurs, Vicon et OptiTrack ont sorti des systèmes d’entrée de gamme. Il est possible de faire de la qualité avec un système de 16 caméras à 4 millions de pixels. « Les studios de taille intermédiaire peuvent ainsi s’équiper en MoCap de manière légère pour faire 80 % des captures en interne et confier les plus complexes en sous-traitance. Cela évite d’investir dans un grand studio qui présente des désavantages comme le prix du foncier, l’obsolescence du matériel, etc. », poursuit Stéphane Dalbera. Cette évolution est confirmée par El Mostafa Laassel, président de Biometrics France, distributeur de plusieurs équipements de MoCap, dont les produits Vicon. « Nous assistons à une baisse du prix des matériels avec des logiciels plus performants, par exemple Shogun chez Vicon, ainsi qu’avec l’arrivée des accéléromètres triaxes qui facilitent le recalibrage. Il est possible de bouger une caméra en temps réel, en utilisant les informations de l’accéléromètre, et le recalibrage s’effectue en temps réel. » Les budgets dévolus à l’équipement continuent de baisser avec des caméras à un ou deux millions de pixels pour moins de 3 000 euros. « Autre atout, le câble réseau de toutes les caméras Vicon est un simple J45 standard, connecté à un switch Ethernet à moins de 1 000 euros, qui suffit pour l’alimentation des caméras », complète El Mostafa Laassel. Par ailleurs, les technologies de capture de mouvements très abordables financièrement se multiplient, tels Lighthouse de Valve (un système de tracking laser pour l’interface SteamVR et le casque HTC Vive), le costume Xsens ou Perception Neuron de Noitom. Mais pour obtenir de la qualité avec ces matériels, un important travail de post-traitement des données est indispensable et parfois impossible à mener. En revanche, les secteurs du divertissement ou de l’événementiel peuvent servir de débouchés à ces solutions, par exemple en animant des avatars stylisés en temps réel. Le transfert de compétences de la MoCap et de la 3D temps réel se poursuit vers d’autres domaines, comme l’architecture et le BIM, le médical, la robotique, ainsi que la formation pour le serious game.

Article paru pour la première fois dans Mediakwest #27, p. 16-18.Abonnez-vous à Mediakwest (5 numéros/an + 1 Hors-Série « Guide du tournage ») pour accéder, dès leur sortie, à nos articles dans leur intégralité.