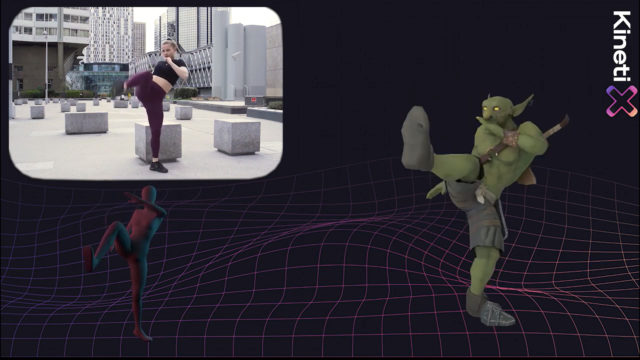

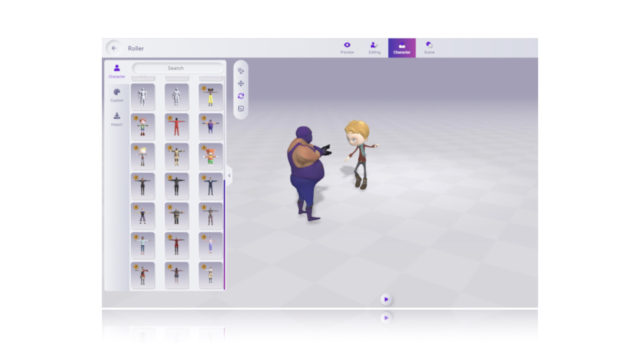

À la tribune des RADI, les outils logiciels d’animation de prochaine génération sont passés en revue. © DR

À la tribune des RADI, les outils logiciels d’animation de prochaine génération sont passés en revue. © DR

Une fois n’est pas coutume, ce ne sont pas les chiffres de l’emploi 2023 et ceux de l’animation qui ont inauguré les Rencontres professionnelles de l’animation, mais une session très dense sur les outils logiciels de prochaine génération.

Les RADI (Rencontres Animation Développement Innovation), qui fêtaient (du 19 au 22 novembre) leur dixième anniversaire (et ont gagné une demi-journée de programmation), se sont employées à passer en revue les outils plus innovants (son, voix, image). Sans oublier de saluer au passage quarante ans d’innovations dans les studios d’animation et la filière hexagonale (forte aujourd’hui de 10 000 emplois) brossées par Valérie …

Abonnez-vous dès maintenant

Accédez en illimité à tous les articles aux dossiers, aux magazines, aux newsletters exclusives…

Je m'abonne Déja un compte? Je me connecte