Comme nous allons le voir, la part de la production de films d’animation 3D et des VFX par l’utilisation des data centers n’est pas négligeable et présente un enjeu incontournable pour la filière audiovisuelle, notamment car les contraintes du CNC entreront en vigueur en 2024.

Fin 2021, Qarnot organisait un meet up dans ses locaux de Montrouge, avec des intervenants de Film Paris Region/Ecoprod, AMD, CG Wire et Qarnot afin d’exposer les enjeux et des mesures concrètes pour réduire l’impact écologique de ce secteur. Les participants étaient principalement des studios d’animation 3D et de VFX, ainsi que des institutionnels comme le CNC et Cap Digital.

État des lieux

Joanna Gallardo, international relations and ecosystem manager chez Film Paris Région et membre du collectif Ecoprod, ouvre le bal en partageant les chiffres élaborés en 2019 par Ecoprod. Dans l’empreinte de l’industrie du numérique, la part de la filière audiovisuelle est de 1,7 million de tonnes de CO2. Le streaming en représente 58 %, en très forte augmentation (x3) depuis 2018. La prise en compte de la fabrication des téléviseurs multiplie ce chiffre par dix.

Les accords de Paris exigent de baisser de -2,3 % les émissions CO2 tous secteurs confondus. Pour la filière audiovisuelle, cela revient à réduire ses émissions carbone de -4,3 % chaque année jusqu’en 2030. L’enjeu est climatique mais aussi économique. En effet, la filière doit rester rentable malgré les contraintes qui vont s’imposer pour réduire cette empreinte, mais aussi pour faire face à la raréfaction de certaines matières premières, comme le cobalt ou le lithium, utilisées dans les caméras, ordinateurs, etc. Dans la mesure où la filière audiovisuelle est non prioritaire, sa viabilité est questionnée.

La loi de Shrek

L’empreinte énergétique du numérique a trois causes principales : la fabrication des équipements (stations de travail, serveurs, TV…), le calcul (utilisation des terminaux et data centers) et le réseau (la diffusion). C’est surtout la partie calcul qui va intéresser ici les participants du meet up, studios d’animations 3D et VFX. Ce calcul de rendu dégage de la « chaleur fatale ». Cette chaleur est considérée comme un « déchet du calcul » et, comme tout déchet, son recyclage est un enjeu.

La « loi de Shrek », nommée ainsi par Qarnot, décrit l’augmentation fulgurante de la quantité de calcul nécessaire dans le film d’animation :

En 2001, Shrek a nécessité 5 millions d’heures de calcul de rendu.

En 2004, Shrek 2 a nécessité 10 millions d’heures.

En 2007, Shrek Le Troisième représentait 20 millions d’heures.

En 2010, Shrek 4 nécessitait 50 millions d’heures.

Il existe trois raisons principales à cette croissance exponentielle : l’augmentation de la résolution des images HD, 4K, 8K, l’accroissement de la fréquence d’image, mais aussi l’amélioration de l’animation et du réalisme. Notons que les 50 millions d’heures de calcul ont été effectuées en 2010 sur du hardware probablement 35 fois plus puissant que celui de 2001.

Nicolas Sainthérant, directeur de l’innovation chez Qarnot, note que « jusqu’à Shrek 4, le nombre d’heures de calcul était un élément mis en avant par les studios pour promouvoir la qualité du film. Depuis lors, il est très difficile d’obtenir ces informations car cet indicateur lié à la pollution numérique ne donne pas une image très vertueuse du studio ».

Il y a 460 programmes de film d’animation en développement dans le monde en 2021 et le nombre de plates-formes de diffusion explose. On compte aujourd’hui 358 plates-formes dans 49 pays et Netflix, à lui seul, représente 15 % du trafic Internet.

Chauffer Paris avec Toy Story 4

Que représentent ces heures de calcul en termes d’énergie ? Une étude effectuée par Ariane Robineau, ingénieur R&D chez Qarnot, permet de mettre en regard l’énergie consommée par la production d’un film d’animation avec l’énergie consommée pour le chauffage des habitants en hiver.

Pour un film comme Toy Story 4, c’est-à-dire un format de 100 min à 24 fps, un temps de rendu moyen de 100 heures par image (sur CPU 16 cœurs) et 15 retakes par image, l’énergie consommée est de 58 320 MWh, principalement dissipée sous forme de chaleur.

Cette même quantité d’énergie aurait permis de chauffer Paris, ville de 2 148 271 habitants, pendant six jours, neuf heures et quatre minutes en plein hiver, ou encore la ville de Quimper (63 000 habitants) pendant plus de 117 jours, c’est-à-dire tout l’hiver et une partie du printemps.

Comment mesurer l’efficacité du calcul ?

Nicolas Sainthérant nous rappelle que ne peut s’améliorer que ce qui se mesure. Parmi les métriques des data centers, deux nous intéressent ici :

- PUE = power usage effectiveness;

- ERE = energy reuse effectiveness.

Le PUE est le ratio entre toute l’énergie qui rentre dans le data center et celle qui est réellement utilisée par les serveurs. L’idéal est le ratio de 1 qui signifie que 100 % de l’énergie est utilisée par les serveurs. C’est la seule métrique vraiment partagée, documentée et communiquée par les data centers. Il est d’ailleurs intéressant de constater que depuis que cette donnée est documentée, elle ne cesse de s’améliorer passant de 2,5 à 1,6 en quelques années. Dans le meilleur des cas, un PUE de 1,6 signifie que 40 % de l’énergie consommée par le data center n’est pas utilisée par les serveurs mais par la climatisation, l’éclairage, etc. Une amélioration a été apportée avec un système de climatisation optimisé où l’air chaud est mieux canalisé pour ne pas se mélanger à l’air froid des allées, mais malgré tout, depuis trois ans, ces gains d’énergie stagnent.

Considérons maintenant un data center avec un PUE=1. Est-ce vraiment satisfaisant sur le plan écologique ? Quelle part de cette chaleur est réutilisée ? Quelle part est gaspillée ? C’est à cette question que répond la deuxième métrique : l’ERE (Efficacité de la Réutilisation de l’Énergie) et c’est là que le système Qarnot prend tout son sens.

Recycler la chaleur fatale avec la chaudière Qarnot

La solution proposée ici par Qarnot est la chaudière à calcul QB1. Elle permet de réutiliser la chaleur fatale produite par ses 300 cœurs de calcul pour chauffer de l’eau et ainsi remplacer avantageusement une chaudière à gaz (qui, elle, ne calcule rien du tout). Cette chaudière QB1 a un PUE de 1 et un ERE de 0,04, ce qui signifie que 100 % de l’énergie consommée est utilisée par le calcul et 96 % de cette énergie se retrouve dans l’eau sous forme de chaleur.

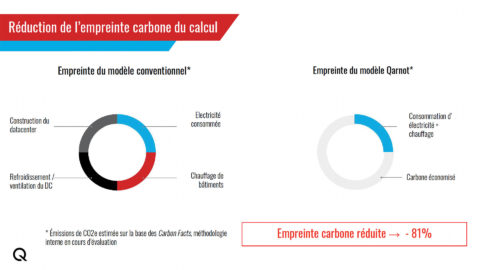

Dans le modèle de data center traditionnel, nous pouvons répertorier trois sources de consommation de l’énergie et des ressources : la construction du data center, la climatisation et le chauffage des bâtiments alentours.

Dans le modèle de Qarnot, deux sources de pollution sont éliminées : la construction du data center (les chaudières se placent dans des bâtiments existants) et la climatisation, car la chaleur n’est pas supprimée mais réutilisée.

Un calcul plus efficace avec AMD

Au cœur des problèmes liés au calcul se trouve le semi-conducteur, composant essentiel du microprocesseur ou processeur graphique (GPU). Pascal Lierbart, responsable marketing chez AMD, vulgarise son fonctionnement : « Un processeur reçoit de l’énergie et en sort du calcul. La propriété des semi-conducteurs est de pouvoir passer de l’état conducteur à isolant électrique. Dès lors qu’on bloque les électrons, on génère de la chaleur appelée waste heat ou chaleur fatale ».

En général, cette chaleur doit être supprimée. Dès lors, 40 % de la facture d’électricité du data center concerne la climatisation. Depuis cinquante ans, l’évolution consiste à produire plus de calcul avec la même quantité d’énergie.

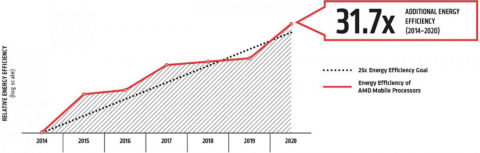

AMD s’était fixé un objectif : l’« Initiative 25×20 » consistant à multiplier par 25 cette efficacité énergétique d’ici 2020. L’objectif a été largement dépassé en multipliant les performances par 5 et en diminuant l’énergie consommée par un facteur de 6,4, réalisant ainsi une amélioration d’un facteur de 31,7 en 2020. (5×6,4). C’est deux fois plus vite que la tendance historique.

Comment ? En passant d’une technologie de 14 nm à 7 nm (moins d’électrons entrent en jeu donc moins de chaleur dissipée), en créant une nouvelle génération d’architecture et en utilisant une gestion de l’alimentation intelligente. Un autre axe d’amélioration est de spécialiser certains produits pour des tâches particulières.

La spirale vertueuse de l’organisation avec CG Wire

Pour les studios d’animation, si les outils de création sont là, performants et accessibles, il manque en revanche (parfois) une bonne organisation et collaboration. Un des axes d’amélioration proposée par Frank Rousseau, fondateur et CEO de CG Wire, est de rendre cette collaboration plus efficace pour éviter le gaspillage.

Frank Rousseau utilise une analogie avec la restauration : « Le serveur transmet en cuisine l’information qu’il faut retirer les noix à cause de l’allergie du client. Si cette info est perdue par le commis, le chef va faire un plat qui sera bon pour la poubelle. Pour une retake, c’est la même chose : si l’info n’est pas bien transmise, alors le studio produit une retake inutile, une génération de preview inutile, un rendu inutile, qui vont gaspiller de l’énergie ».

L’outil Kitsu de CG Wire est une plate-forme de collaboration permettant de tracker l’avancement des productions. Pour simplifier, c’est un tableau avec des tâches, et sur chaque tâche il est possible d’échanger. Une spirale vertueuse se met en place dès lors que, sur la plate-forme, les décisions prises sont enregistrées sous forme de données accessibles à toutes les autres parties prenantes du projet. Elles-mêmes prendront de meilleures décisions car elles sont mieux informées et feront moins d’erreur. Dans la mesure où ces plates-formes suivent des coûts financiers, on peut imaginer qu’elles suivent aussi des coûts carbone.

Pour conclure, au-delà des problèmes énergétiques, il y a les problèmes d’extractions des ressources liées à la fabrication des équipements ainsi les terres, les métaux qui se font rares, et même l’eau. Les équipements numériques se recyclent très mal. Changer trop souvent ses équipements a un impact écologique certain. « L’acte écologique le plus simple est de prolonger la durée de vie des équipements », conclut Nicolas Sainthérant.

Évolution du nombre d’heures de calcul de rendu des quatre films Shrek

- 2001 > Shrek 1 > 5 millions d’heures

- 2004 > Shrek 2 > 10 millions d’heures

- 2007 > Shrek 3 > 20 millions d’heures

- 2010 > Shrek 4 > 50 millions d’heures

*source : Lean ICT – Towards digital sobriety – mars 2019

Article paru pour la première fois dans Mediakwest #45, p. 72-75