L’Ultra Haute Définition (UHD) entre déjà dans une seconde étape de sa courte vie. Après avoir prôné l’augmentation de la taille de l’image avec le slogan « plus de pixels », les industriels et les diffuseurs orientent leur stratégie vers de « meilleurs pixels ». Pour cela, ils mettent en avant trois procédés : l’extension de la palette des couleurs avec le WCG (Wide Color Gamut) défini dans la Rec. 2020, l’augmentation de la fréquence des images avec le HFR (High Frame Rate) et enfin le HDR (High Dynamic Range) pour étendre la dynamique des images entre les basses et hautes lumières.

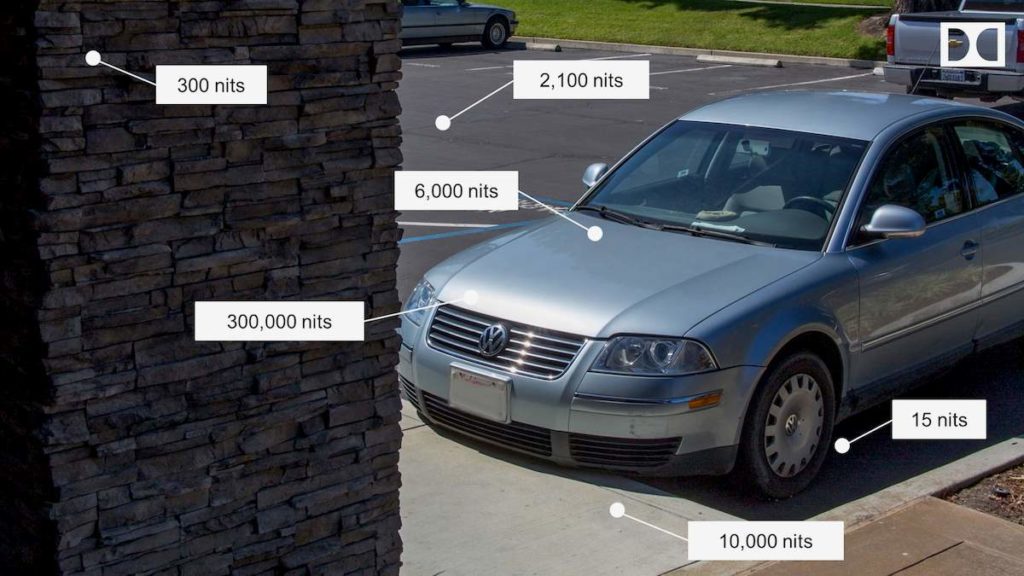

Longtemps les performances de la chaîne de traitement vidéo, depuis la caméra jusqu’au téléviseur, ont été limitées en termes de dynamique lumineuse, à la fois à cause de la sensibilité des capteurs des caméras (d’abord à tubes puis à CCD), de la puissance lumineuse des écrans à tube cathodique, limitée à 100 cd/m2 (ou nits) et surtout de la fameuse courbe de correction de gamma avec une valeur de 0,45 dans la caméra et de 2,2 côté affichage. Les images visibles présentent une échelle de luminosité très vaste allant du 1/1 000 000 de nit pour une nuit noire sans lune jusqu’au milliard de nits pour le soleil direct.

La vision humaine s’adapte en permanence à de tels écarts grâce à l’iris de l’œil et accepte un ratio de 100 000. Dans le passé, la chaîne vidéo constituait un véritable entonnoir puisqu’une image était reproduite sur le tube cathodique avec une puissante de 100 nits et un noir de 0,1 nit, soit un rapport de 1 000. Les capteurs des caméras récentes offrent une latitude de pose plus élevée, annoncée avec des valeurs de 13 ou 14 ouvertures de diaphragmes. Les écrans LCD voient la puissance de leurs LED augmenter et passer de 250 ou 300 nits à environ 800 ou 1 000 pour des modèles grand public ou même 4 000 nits pour des modèles industriels. La courbe de transfert habituelle en gamma ne voit plus sa raison d’être, puisque les tubes cathodiques sont abandonnés. Depuis plusieurs années, les fabricants de caméras ont proposé des courbes logarithmiques spécifiques respectant mieux la dynamique améliorée de leurs capteurs. Il était donc temps de tout remettre à plat et de proposer une nouvelle chaîne de traitement offrant une meilleure dynamique aux images.

Distinguer postproduction et diffusion

Avant de faire le point sur l’avancement des travaux autour du HDR, il faut distinguer les deux secteurs où cette technologie va se déployer : d’un côté la production de contenus en tournage/postproduction ou en direct et de l’autre la diffusion ou distribution vers le téléspectateur. Plusieurs technologies concurrentes sont actuellement testées et comparées en vue d’une validation pour une normalisation. Il est fort possible que plusieurs d’entre elles soient exploitées en parallèle, chacune présentant des avantages et des inconvénients. Sur le versant production, cette situation n’est pas critique à gérer car les exploitants maîtrisent à la fois les équipements de captation, de traitement et d’affichage. Changer de paramètres ou de mode de codage du HDR, codé si possible sur 12 bits pour préserver la qualité, compliquera un peu les procédures, mais sera possible sur l’ensemble des équipements, avec une mise à jour de firmware ou un plug-in logiciel. La situation sera similaire à celle des formats d’enregistrement ou des codecs de compression où de multiples versions cohabitent dans les centres de production.

Par contre pour la diffusion, la situation est plus complexe ou risquée. Une fois le contenu diffusé, il ne reste plus qu’à espérer qu’il sera correctement affiché chez le spectateur. D’où l’importance des métadonnées l’accompagnant pour configurer l’écran dans le bon mode et avec les paramètres corrects. Il sera nécessaire de veiller à la conformité des téléviseurs ou décodeurs et à leur mise à jour si le codage évolue. Reste la question de la rétrocompatibilité avec les écrans non HDR, qualifiés alors de SDR (pour Standard Dynamic Range) et surtout les premiers modèles HDR actuellement vendus, pour lesquels une mise à jour vers le choix définitif du HDR ne semble pas totalement garantie.

Passer du gamma à la courbe OETF

Les travaux autour du HDR ont démarré il y a déjà plusieurs années en laboratoire. La courbe de transfert lumière électricité classique avec la correction de gamma a montré ses limites, en particulier pour le traitement des hautes lumières. Elle avait été définie par rapport aux caractéristiques électroluminescentes des tubes cathodiques. Ceux-ci ayant disparu, elle pouvait être abandonnée pour passer à un autre type de courbe mieux adaptée aux performances des équipements actuels. Dans la caméra ou au moment de la conversion des fichiers Raw, les ingénieurs, pour passer du 8 ou 10 bits vers les traitements à 12, 14 ou 16 bits, ont conçu d’autres courbes de conversion offrant plus de latitude pour le codage de la couleur ou les effets spéciaux. Pour ne plus caractériser ces courbes selon leur formule mathématique, linéaire, logarithmique, knee ou gamma, on leur attribue le nom générique OETF – pour Opto Electrical Transfer Function. Au niveau de l’affichage, la courbe inverse EOTF – pour Electro Optical Transfer Function – effectue la conversion des valeurs numériques du signal en niveaux lumineux pour l’affichage.

Ces courbes de transfert peuvent être définies selon de nombreuses formules mathématiques. Les fabricants de caméras ne s’en sont d’ailleurs pas privés. Mais, dans une chaîne de diffusion, l’écran d’affichage doit disposer de la courbe inverse de celle utilisée à la prise de vues ou au codage. D’où l’obligation impérieuse d’une normalisation.

De nombreuses propositions techniques ont été lancées par les industriels. Actuellement seules quatre restent en course : celle de la BBC, à laquelle s’est rattachée la proposition de la NHK, celle de Dolby avec Dolby Vision, Philips et enfin Technicolor.

Les quatre projets en course

La proposition de la BBC est basée sur une courbe OETF dite hybride. De 0 à 100 nits, la courbe suit celle du gamma traditionnel, proche de celle de la rec. 709, et au-dessus de 100 nits suit une courbe logarithmique, d’où la dénomination HLG pour Hybrid Log Gamma. Cette nouvelle courbe OETF peut être considérée comme une évolution de la courbe en « knee » utilisée depuis des années en production et avec une valeur lumineuse maximale augmentée. Le passage d’un codage 8 bits vers 10 bits offre 2 bits supplémentaires pour le codage des hautes lumières pour atteindre les 5 000 nits et reste compatible avec les écrans SDR. Lors de l’IBC 2015, une démonstration d’un signal HDR codé en live pouvait être affichée directement sur un écran SDR sans défaut perceptible. Comme le codage est effectué sur 10 bits sans augmentation de débit, elle n’implique pas de modifications dans les infrastructures de production et de diffusion.

Dolby regroupe l’ensemble de ses propositions pour améliorer la perception des images vidéo et cinéma sous le terme générique Dolby Vision. Cela englobe à la fois des procédés de codage qui vont au-delà des performances des standards reconnus pour la dynamique lumineuse, le codage couleur et le rendu au niveau de l’affichage, mais aussi des outils logiciels et hardware pour maîtriser cette amélioration. L’objectif est de définir un écosystème global autour du codage, du traitement et de la restitution de l’image animée, comme l’entreprise l’a fait avec succès autour de la restitution sonore.

Pour la partie HDR, Dolby s’appuie sur la courbe de Barten. À partir de travaux sur l’évaluation subjective de la qualité des images, cet ancien ingénieur de Philips a défini un modèle psycho-visuel de détection du contraste par l’œil humain. Il montre que l’écart de contraste détecté varie en fonction du niveau lumineux affiché. Si la courbe de transfert de l’afficheur est au-dessus de la courbe de Barten, des effets de seuillage seront visibles à l’écran. Pour les courbes de transfert en dessous de la courbe, il n’y a aucun défaut visible. Les chercheurs de Dolby ont donc défini une courbe OETF la plus proche du modèle de Barten. Cette courbe de transfert est appelée « Perceptual Quantization » ou PQ et a fait l’objet d’une normalisation auprès de la SMPTE sous le n° ST 2084. Selon le domaine d’utilisation, elle est codée sur 12 bits pour les travaux de postproduction, et donc placée au-dessous de la courbe de Barten. Dolby Vision est le seul système de gestion du HDR fonctionnant avec une précision de 12 bits. Codée sur 10 bits et réservée à la diffusion pour des images un peu plus bruitées, elle se trouve au-dessus de la courbe de Barten, mais sans défaut réellement perceptible. C’est cette courbe PQ 10 bits qui a été choisie pour le Blu-ray UHD. On emploie aussi dans ce cas le vocable HDR10 qui englobe à la fois la norme SMPTE ST-2084 (courbe PQ 10 bits) et le codage des métadonnées statiques normalisées selon la norme SMPTE ST-2086.

Mais l’univers Dolby Vision ne s’arrête pas à cette simple courbe OETF. Il comprend toute une série d’outils au niveau postproduction pour enrichir les images, maîtriser un codage couleur amélioré, et le décrire avec des métadonnées pour que l’écran compatible Dolby Vision puisse les reproduire au mieux en fonction de ses caractéristiques propres. Les métadonnées statiques liées à l’écran sont déjà standardisées selon la norme SMPTE ST-2086. Les métadonnées dynamiques dépendant du contenu sont en cours de normalisation.

Les outils permettent aussi de décliner les versions Dolby Vision adaptées au cinéma, à la TV, les versions HDR simples, de préparer les versions SDR et enfin de gérer le passage du 12 aux 10 bits pour la diffusion. Dans ce but, Dolby a développé le Content Mapping Unit (CMU) pour permettre à un étalonneur ou un ingénieur vision de visualiser la déclinaison SDR « automatique » de son signal HDR.

Dolby fournit des plug-in pour intégrer sa technologie dans des logiciels comme Baselight d’Avid, Davinci Resolve, Autodesk Lustre, FilmMaster de Nucoda ou Premiere. Enfin la société travaille avec des fabricants de puces (Realtek, MediaTek, HiSilicon) pour intégrer sa technologie dans les circuits de traitement des téléviseurs HDR. Pour assurer la compatibilité avec les téléviseurs existants non HDR, Dolby a prévu un système de diffusion à deux couches. La couche principale contient les données pour les images SDR et elle est décodée par les TV standard tandis que la seconde couche contient les données complémentaires liées au HDR et en associant les deux couches, une TV HDR pourra reproduire les images avec contenu HDR.

Ce codage à deux couches conduit à une augmentation du débit numérique de 15 % environ, d’après Dolby. Cela peut poser un problème au niveau de la diffusion des émissions de TV linéaire, les gabarits des canaux étant alors à modifier. La version monocouche permet de convoyer des courbes 12 bits dans un transport en HEVC codé sur 10 bits.

La proposition de Philips est également basée sur une courbe de transfert PQ 10 bits conforme à la SMPTE ST-2084. Le signal peut être codé de deux manières, soit en flux HDR avec métadonnées associées détaillant la conversion SDR au prix d’une légère augmentation de débit. Une transmission en mode SDR est également prévue avec reconstruction de l’image HDR depuis les métadonnées. Dans ce cas, le contenu HDR est légèrement dégradé par rapport à la solution Full HDR. Dans les deux configurations le signal peut être affiché sur un écran HDR ou SDR.

À partir de son expérience sur le traitement vidéo et les effets spéciaux, Technicolor a apporté sa pierre à l’édifice. L’entreprise a conçu un système basé sur un pré-processing à l’encodage et un post processing dans le décodeur. La courbe OETF utilisée est également de type PQ 10 bits. L’entreprise défend par contre le principe d’une solution « open » basée sur un codage simple couche afin de préserver la compatibilité avec les écrans SDR. Le principe est de coder l’information HDR dans des métadonnées accompagnant le flux SDR et sans augmenter la bande passante. Technicolor met aussi en avant une technologie propriétaire dénommée ITM pour « Intelligent Tone Management », destinée à fournir un signal HDR à partir d’une source SDR. Cette solution permettrait d’upscaler des contenus existants, en particulier HD, pour les diffuser rapidement vers des terminaux HDR.

Sur les quatre propositions, trois utilisent une courbe OETF PQ normalisée SMPTE ST-2084. Par contre la gestion des métadonnées associées reste spécifique à chacune d’elles, ce qui rend leur codage propriétaire.

Cet article est publié en 2 parties : pour lire la seconde partie, cliquez-ici. Vous pouvez consulter l’article dans son intégralité, tableaux et graphiques, dans le numéro #14. Abonnez-vous pour recevoir les articles complets dès leur sortie ! )