Le big data révèle une série de technologies convergentes de plus en plus accessibles à des entreprises de taille moyenne qui voudraient générer de la valeur à partir d’importants volumes de données récoltées, triées et modélisées au sein de services de plus en plus en temps réel.

Si la maîtrise de ces technologies est encore réservée à un écosystème de spécialistes, les grands principes du big data commencent à être compris : du crawl à l’indexation des contenus, en passant par l’analyse sémantique, statistique, les algorithmes prédictifs, les architectures de calcul et de stockage distribuées, les algorithmes et le cloud computing.

Le cloud computing, compagnon du big data

Le big data étant la plupart du temps associé à des volumes de calcul importants durant des périodes souvent assez courtes, le cloud computing et sa capacité à mobiliser de la ressource informatique de manière forte et temporaire en est le compagnon idéal. Il s’inscrit dans un mouvement plus vaste de transformation des entreprises de l’audiovisuel.

Denis Vergnaud, P-DG de la société de conseil et d’ingénierie broadcast, 42 Consulting, aborde d’ailleurs le big data comme un outil parmi d’autres permettant aux acteurs de l’audiovisuel d’avancer sur le chemin de la valorisation de leur contenu sur les réseaux, devenus des marchés très concurrentiels.

« Au sein de 42 Consulting, nous abordons le big data sous différents angles, allant de l’architecture réseau à la mise en place de modèles d’analyses des données via des Data Scientists, jusqu’au développement d’algorithmes au sein des infrastructures techniques de nos clients. »

De même, il existe des spécificités à l’usage du big data dans les médias audiovisuels, ne serait-ce que par la profusion de données qu’induit l’analyse des audiences en temps réel des intentions d’achat sur un portail sVOD ou le taux de visionnage d’une vidéo et de publicités. Les volumes générés sont généralement plus importants que dans d’autres secteurs marchands et ces données d’audience sont la matière première du média qui en tire une valorisation de revenus publicitaires ou un taux de transformation.

Pour autant, la prise de conscience de l’intérêt d’aller vers le big data est assez récent : « Les acteurs traditionnels de l’audiovisuel ne sont pas tous au même stade de maturité », indique Denis Vergnaud. « L’implémentation des technologies big data dans leur architecture informatique est encore loin du niveau d’acteurs mondiaux des services OTT que sont Netflix, Amazon ou Google. Cependant, entre la mi-2016 et aujourd’hui, nous avons franchi un cap. Toutes les chaînes TV et opérateurs de bouquets ont compris l’intérêt du big data et ont entamé des projets de transformation numérique de leur entreprise en intégrant cette dimension. »

Le data lake n’est pas la panacée

En matière de big data, le concept très en vogue est celui de « data lake » ou lac de données. L’idée générale du data lake est de disposer d’une plate-forme de stockage globale des flux de données entrant au sein de son entreprise, en ayant suffisamment de flexibilité pour interagir avec l’ensemble de ces données, qu’elles soient brutes ou très raffinées. L’absence de schéma strict imposé aux flux entrants permet d’insérer toutes les données, quelles que soient leur nature et leur origine.

Aussi séduisant que soit en théorie le concept de data lake, les initiatives autour de ce genre de plate-forme technique restent encore peu nombreuses et limitées par les difficultés inhérentes aux phases de collecte et d’ingestion dans les systèmes d’information existants qui fonctionnent encore par silos informatiques.

« Définir un data lake et sa gouvernance », souligne Denis Vergnaud, « est un processus complexe à mettre en œuvre, qui peut retarder le lancement d’une démarche big data au sein d’une organisation. C’est pourquoi nous préférons commencer par utiliser le big data au sein d’un silo de données afin de tester la démarche à tous les échelons de décisions de l’entreprise et de généraliser ensuite pas à pas, de manière pragmatique. Dans le monde audiovisuel, le premier silo concerné par le big data est généralement une activité proche du client final, comme la distribution des programmes. »

« Quand on démarre une démarche big data », insiste Ludovic Maux, le responsable big data chez 42 Consulting, « on se focalise sur l’exploration des données liées à la “Qualité de l’Expérience Utilisateurs”. Sur ce point, après quelques semaines d’exploration seulement, on peut obtenir des résultats probants qui génèrent des plans d’action améliorant nettement la qualité d’un service. »

Les outils de récolte et d’analyse préconisés par la société de conseil sont généralement open source et parmi les plus répandus du marché. Citons, en exemple, le fameux framework de traitement des données non structurées Hadoop ou son équivalent Apache Spark ou encore des logiciels d’exploration des données comme ElasticSearch, Logstash, Kibana, ainsi que la technologie de gestion des bases de données NoSQL (voir glossaire).

Analyse des données en batch ou en temps réel

Généralement, la logique veut que l’on teste sa capacité à gérer du big data en réalisant un modèle de filtrage et d’analyse en mode « batch », c’est-à-dire à partir d’un jeu de données journalier qui permet de déployer un traitement très volumineux sans mobiliser des moyens et des outils trop consommateurs de ressources de calcul.

Le mieux pour comprendre l’intérêt du batch vis-à-vis du temps réel est de prendre un cas d’usage. 42 Consulting montrait récemment une solution baptisée « Pirate Tracker » testée d’abord en batch puis adaptée en temps réel. Pirate Tracker répond à la problématique d’un acteur média ayant l’intuition que les contenus distribués par sa filiale digitale ne vont pas assez en sortie de CDN vers ses propres sites web et applications, mais vers des acteurs tiers. 42 Consulting lui propose donc de catégoriser toutes les nuits l’ensemble des contenus sortant du CDN, afin de déterminer quelles sont les sessions de consommation légitimes et… les autres.

Ce Pirate Tracker a d’abord nécessité une analyse métier pour être en mesure de déceler les « patterns » de consommation « normaux » et « anormaux ». Des solutions ont ensuite été trouvées pour « blacklister » les adresses IP des serveurs qui distribuent sans autorisation les contenus de ce client. Le modèle ayant été validé quotidiennement, 42 Consulting a ensuite basculé vers le temps réel, afin d’accentuer la pression sur les usages illicites de ces programmes streamés. Notons que ce phénomène de reprise illicite des flux streamés est aujourd’hui particulièrement prégnant sur les retransmissions sportives, dont les ayants droit constatent de lourdes pertes de revenus qu’il faut pouvoir cerner et limiter.

Le big data pour améliorer l’UX

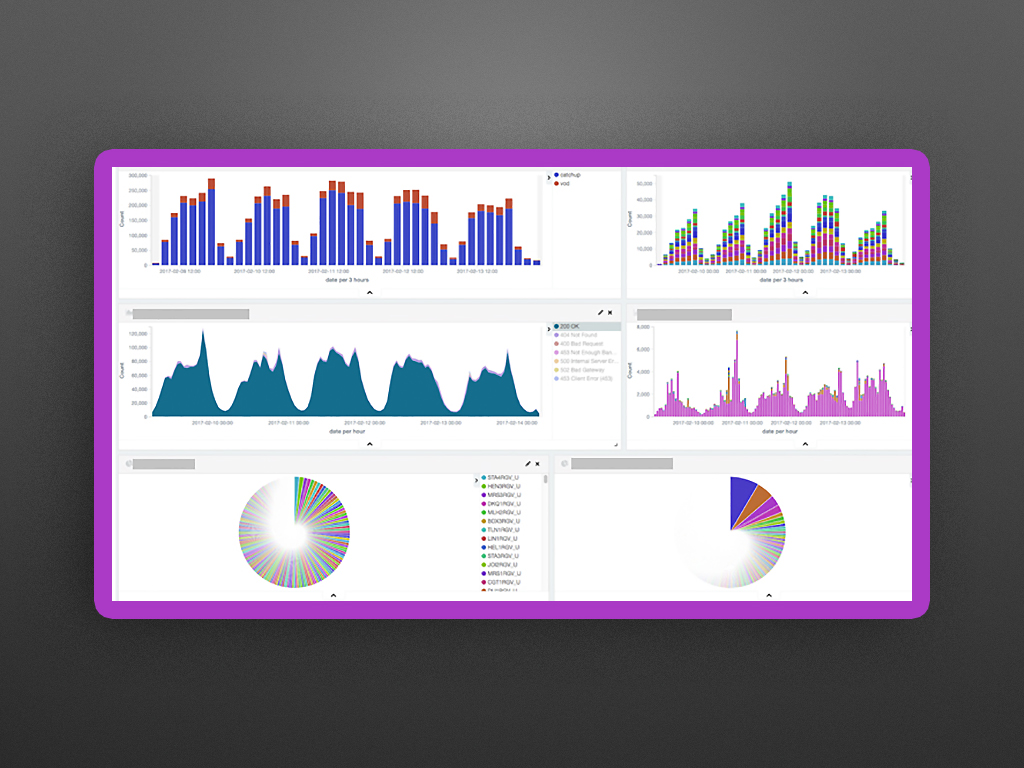

Le big data trouve aussi son application dans le contrôle de la qualité d’un service sVOD via l’analyse technique de tous les « logs » d’utilisateurs durant une journée. Cette analyse sur plus de 8 milliards de logs par jour, permet de mieux connaître la qualité de service à n’importe quel endroit de l’infrastructure de distribution d’un programme et de pointer du doigt rapidement les parties de l’infrastructure technique victimes de pannes ou de dysfonctionnements.

Pour traiter un tel volume de données, il est nécessaire de mettre en place des outils de calcul distribués et de « processer » les flux de données de manière intelligente. Dans ce cas d’usage, 42 Consulting a préconisé, après une première étape d’analyse en batch, de passer à un mode temps réel avec des alarmes quand une défaillance de l’infrastructure survient. À terme, il est même tout à fait envisageable d’introduire de l’intelligence dans le système pour modéliser les pannes récurrentes et être en mesure de les anticiper.

Le big data représente également un intérêt certain pour les services de vidéo à la demande dont la consommation multi-devices est devenue la règle. À l’aide d’une analyse big data de l’audience tout au long du parcours d’utilisation, il est en effet possible d’avoir une connaissance fine de la qualité de l’eXpérience Utilisateur (UX) et de savoir grâce aux résultats du testing A/B où il est nécessaire de porter ses efforts vis-à-vis de l’ergonomie et de la recommandation, par exemple.

Hortonworks est un des principaux spécialistes mondiaux du big data. Il a la particularité d’être depuis 2016 la solution sur laquelle s’appuie la plate-forme de sVOD d’Arkena. Hortonworks Data Platform (HDP) utilise l’ensemble des outils open source du framework Hadoop, afin de répondre å des problématiques d’amélioration d’UX.

« La qualité de l’expérience s’avère tout aussi importante que la qualité du contenu », expliquait en 2016 Reda Benzair, vice-président Technical Development Content Workflow et CDN South chez Arkena. « Une personne sur cinq met immédiatement un terme à une mauvaise expérience de lecture vidéo ».

C’est en faisant ce constat grâce à de nombreuses métriques intégrées au sein d’une plate-forme big data qu’Arkena a pu mesurer l’impact positif de l’implémentation du protocole de streaming adaptatif Dynamic Adaptive Streaming over HTTP (DASH) sur l’augmentation du volume, ainsi que du débit des données lors des montées en charge. À noter que la plate-forme Hortonworks HDP est disponible en mode locatif sur les grands clouds comme Google Cloud, Azure et Amazon.

* Extrait de l’article paru pour la première fois dans Mediakwest #21, p.68-74. Abonnez-vous à Mediakwest (5 nos/an + 1 Hors série « Guide du tournage) pour accéder, dès leur sortie, à nos articles dans leur totalité.

La partie II de cet article sera publiée le 27 Juillet….